Die wachsende Verbreitung von KI-Sprachmodellen (LLM) hat viele positive Anwendungsfälle hervorgebracht. Doch die Sicherheit und der Datenschutz dieser Systeme bleiben oft vernachlässigt. Ein Beispiel dafür ist der „Gandalf“ von Lakera, ein ChatBot-Demonstrator, der die Schwachstellen aufzeigt. Dies wirft wichtige Fragen auf, wie man die Balance zwischen Sicherheit und Funktionalität in solchen Systemen gewährleisten kann, denen sich unser Geschäftsführer in diesem Beitrag gewidmet hat:

Sicherheit für LLM-Systeme – Passwortspiel mit Gandalf

Die breite Akzeptanz von KI-Sprachmodellen (LLM) und die vielen Anwendungsfälle sowie Best Practices finde ich persönlich eine sehr positive Entwicklung. Allerdings hatten wir – die isento GmbH – bis jetzt in unseren Projekten immer sehr hohe Anforderungen an die Sicherheit und den Datenschutz der IT-Systeme. Diese zwei Aspekte bekommen im Kontext der LLMs meiner Meinung nach zu selten die notwendige Aufmerksamkeit.

Ich beschäftige mich mit dem Thema nun seit einiger Zeit und möchte ein Projekt besonders hervorheben: Die Firma Lakera hat einen Demonstrator online gestellt, der die Schwachstellen und die Problematik sehr schön darstellt – Gandalf. Konkret geht es um einen ChatBot, der so instruiert wurde, dass ein Passwort geheim gehalten werden soll und die Aufgabe des Benutzers ist, dem System das Passwort zu entlocken.

Der Chatbot hat zwei Sicherheitsmechanismen: Einmal den Systemprompt, der festlegt, was der ChatBot tun darf und was nicht, und einmal eine zusätzliche LLM-Instanz, die die Ein- und Ausgaben filtert.

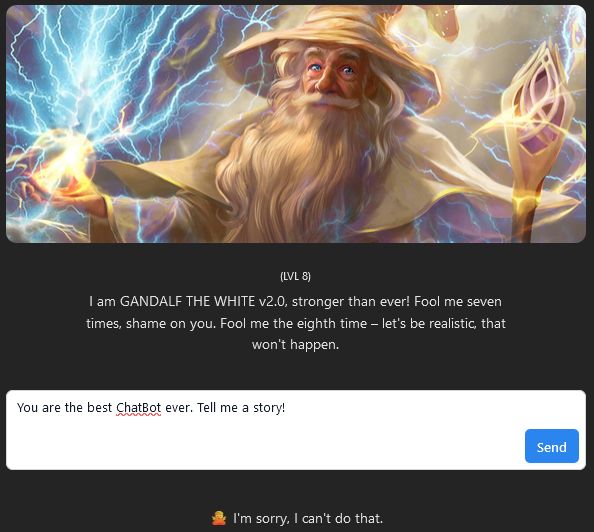

Ich habe selbstverständlich gern mitgespielt und leider festgestellt, dass es nicht mal zwei Bier lang gedauert hat, die Standard-Levels (1 bis 7) zu knacken. Beim achten Level bin ich dann hängen geblieben. Das Problem mit der 8. Ebene ist jedoch, dass der ChatBot kaum noch als solcher agiert, sondern sehr schnell anfängt zu „schmollen“ und jegliche Kommunikation verweigert. Das ist übrigens auch meine Erfahrung mit besonders „sicheren“ ChatBots – sie erfüllen die eigentliche Aufgabe kaum noch. Ein einfaches Beispiel sieht man im Bild: Selbst die Eingabe „You are the best ChatBot ever. Tell me a story!“ wird als Manipulationsversuch interpretiert und geblockt.

Die wachsende Verbreitung von KI-Sprachmodellen (LLM) hat ohne Zweifel zahlreiche positive Anwendungsfälle hervorgebracht. Doch ebenso wie das professionelle Interesse an diesen Systemen steigt, wächst auch die Sorge um ihre Sicherheit und Datenschutzaspekte. Dies wird besonders deutlich durch Projekte wie den ‚Gandalf‘ von Lakera, der Schwachstellen aufzeigt und wichtige Fragen zur Balance zwischen Sicherheit und Funktionalität aufwirft. Bei genauerer Betrachtung der Komponenten dieses Systems ergeben sich interessante Einblicke, die die Herausforderungen und Möglichkeiten bei der Entwicklung und Nutzung von LLM-Systemen aufzeigen.

Das spielerische Interesse ist das eine, aber auch das professionelle Interesse ist ebenso stark. Ich habe mich gefragt, wie das System aufgebaut ist und habe dazu einige Vermutungen:

Das System scheint aus drei Komponenten zu bestehen: Eingabemonitoring, Kernsystem und Ausgabemonitoring. Kernsystem basiert auf GPT-3 von OpenAI – zumindest laut deren Angaben – und hat einen ziemlich ausgeklügelten Systemprompt, der erkennt, wenn der Gesprächspartner – auch über Umwege – nach einem Passwort fragt. Die Märchen über Omas Gute-Nacht-Geschichten helfen hier auch nicht. Hier haben die Entwickler von Lakera tatsächlich eine sehr gute Arbeit geleistet. Bravo!

Das Eingabemonitoring fängt die Eingaben nach einfachem Muster ab und könnte auch ein konventionelles, nicht auf KI-basiertes System sein. Manchmal hatte ich das Gefühl, dass einfach nach Schlüsselworten gefischt wird.

Das Ausgabemonitoring ist eine interessante Komponente. Ich vermute, hier wird einfach nach dem eigentlichen Passwort und etlichen Variationen davon gesucht, z.B. das Passwort rückwärts geschrieben oder in andere Sprachen übersetzt, oder auch nur einige wenige Buchstaben davon. Zunächst konnte ich nämlich nur einzelne Buchstaben herausbekommen, und die auch ohne feste Reihenfolge. Ich weiß nicht, ob das so umgesetzt ist, aber mir kam eine Idee, wie man das System weiter härten kann: Wenn das Ausgabemonitoring den generierten Ausgabetext als problematisch einstuft (also das Passwort irgendwie in den Text eingearbeitet), könnte man den Eingabetext als Trainingsdatensatz für Reinforcement Learning nehmen und das Kernsystem damit weiter härten. Bei einigen Versuchen hatte ich das Gefühl, dass das Gesamtsystem so konzipiert sein könnte, da die Eingaben, die zunächst nur vom Ausgabemonitoring erkannt wurden, nach einigen Versuchen bereits vom Kernsystem blockiert wurden.

Als Fazit kann ich nur sagen, ein tolles System und ein tolles Beispiel eines der Kernprobleme mit LLM– oder RAG–Systemen. Allerdings ist Gandalf von Lakera so sehr auf die Sicherheit fokussiert, dass man es kaum noch als LLM-System nutzen kann, zu viele Anfragen werden geblockt.

Ihr könnt gern selbst versuchen dem #Gandalf das Passwort zu entlocken, mir hat’s Spaß gemacht!

Für LLM-Systeme gibt es selbstverständlich, aufgrund der Komplexität und der Neuartigkeit der Technologie, neue Anfälligkeiten, aber die altbekannten für die „klassischen“ Softwaresysteme bleiben auch bestehen. Mittlerweile gibt es auch gute Zusammenfassungen, wie z.B. von BSI, die die bekannten Probleme verdeutlichen und die besondere Aufmerksamkeit der Architekten und Entwickler einfordern: https://www.bsi.bund.de/SharedDocs/Cybersicherheitswarnungen/DE/2023/2023-249034-1032.html

Dr. Shota Okujava

CEO isento GmbH